赛迪观点:欧盟抢跑人工智能立法,规制数字技术风险

当前,全球数字经济正逐渐向以人工智能(AI)为核心驱动力的智能经济新阶段迈进。AI 技术在各行业得到广泛应用,但在为经济和社会发展注入新动能的同时,也带来了监管难题。为此,2021 年 4 月,欧盟发布《人工智能法》1提案(以下简称《法案》), 提出了 AI 统一监管规则,旨在从国家法律层面限制 AI 技术发展带来的潜在风险和不良影响,使 AI 技术在符合欧洲价值观和基本权利的基础上技术应用创新得到进一步加强,让欧洲成为可信赖的全球 AI 中心。作为 AI 领域的“GDPR”2,该《法案》是全球 首部 AI 管制法律,研究其内容和创新点,对制定我国 AI 等数字技术治理方案具有重要借鉴意义。

一、《法案》核心内容

宽泛定义了 AI 系统,并设置了 AI 规则的域外适用性。

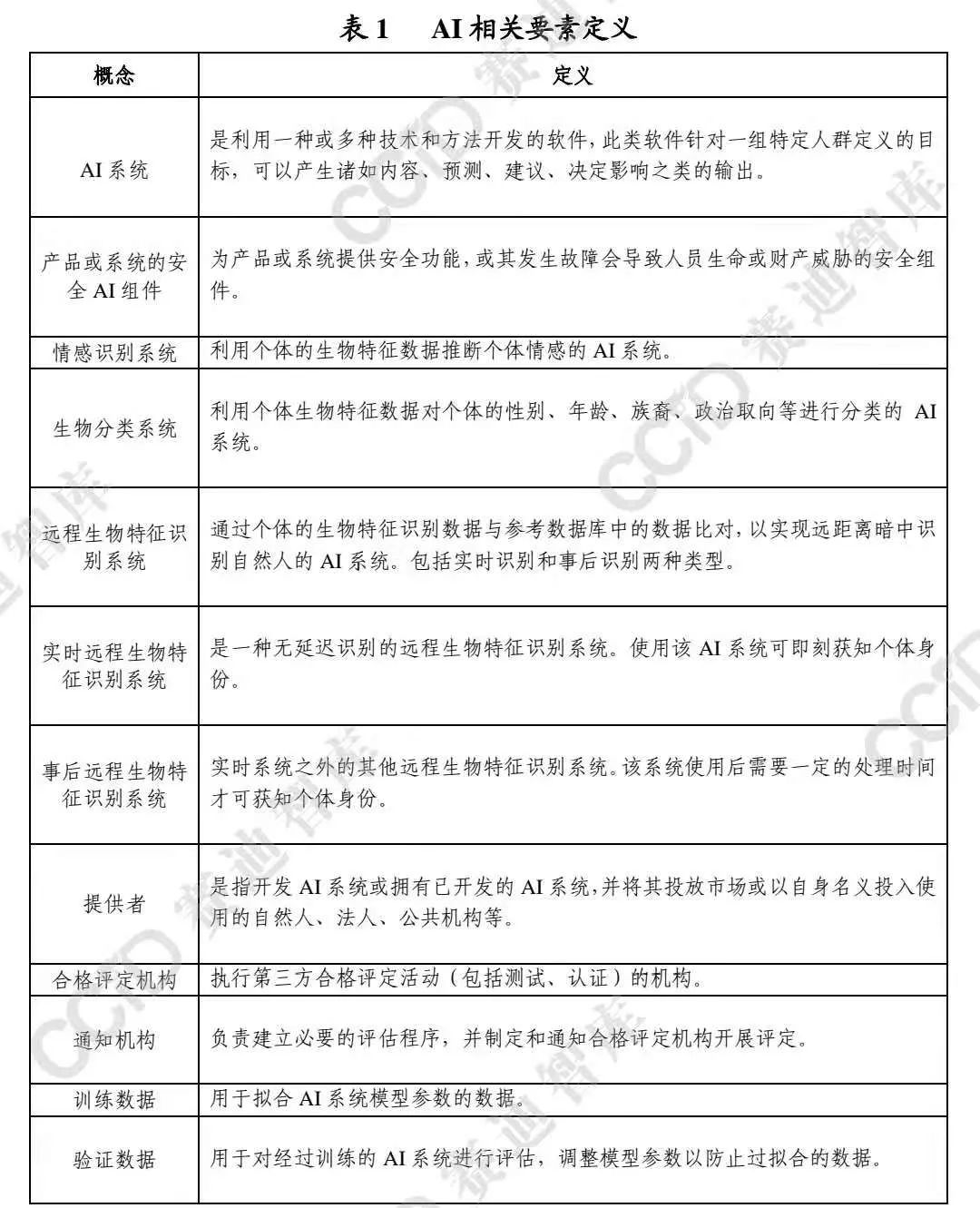

一方面,《法案》定义了 AI 系统、AI 系统供应链上涉及到的相关环节以及不同类别的 AI 数据等相关要素,对监管对象(AI 系统)的定义表现出极强的宽泛性,几乎涵盖了全部使用传统及新兴 AI 技术的系统(AI 技术使用常态化的互联网服务均为监管对象), 与GDPR中对受监管的个人数据的宽泛定义保持一致。

另一方面,《法案》明确了所有在欧盟市场投放、使用 AI 系统及相关服务的国内外供应商、服务商和公共服务用户提供者,只要其 AI 系统影响到欧盟及欧盟公民的,均将受到《法案》约束,从而保证了 AI 规则的域外适用性。

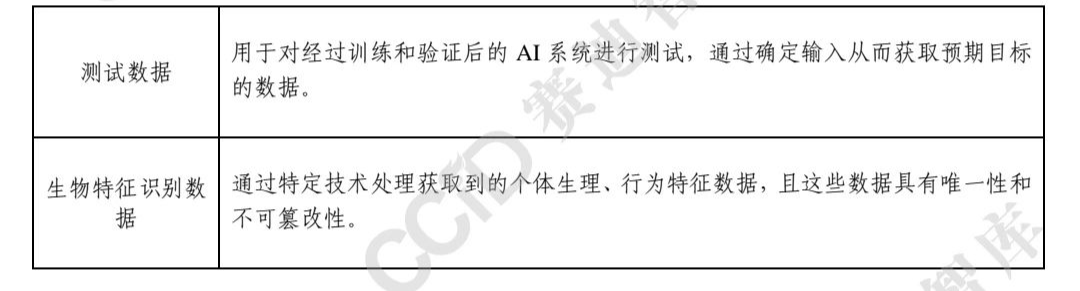

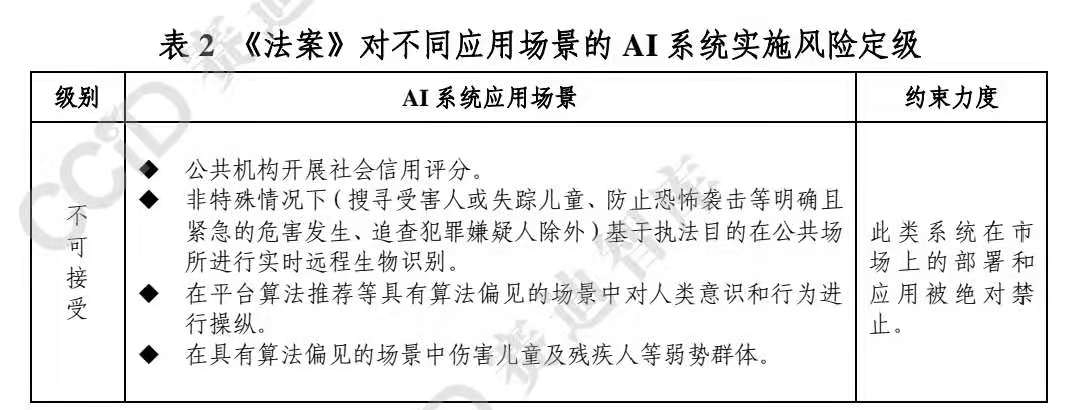

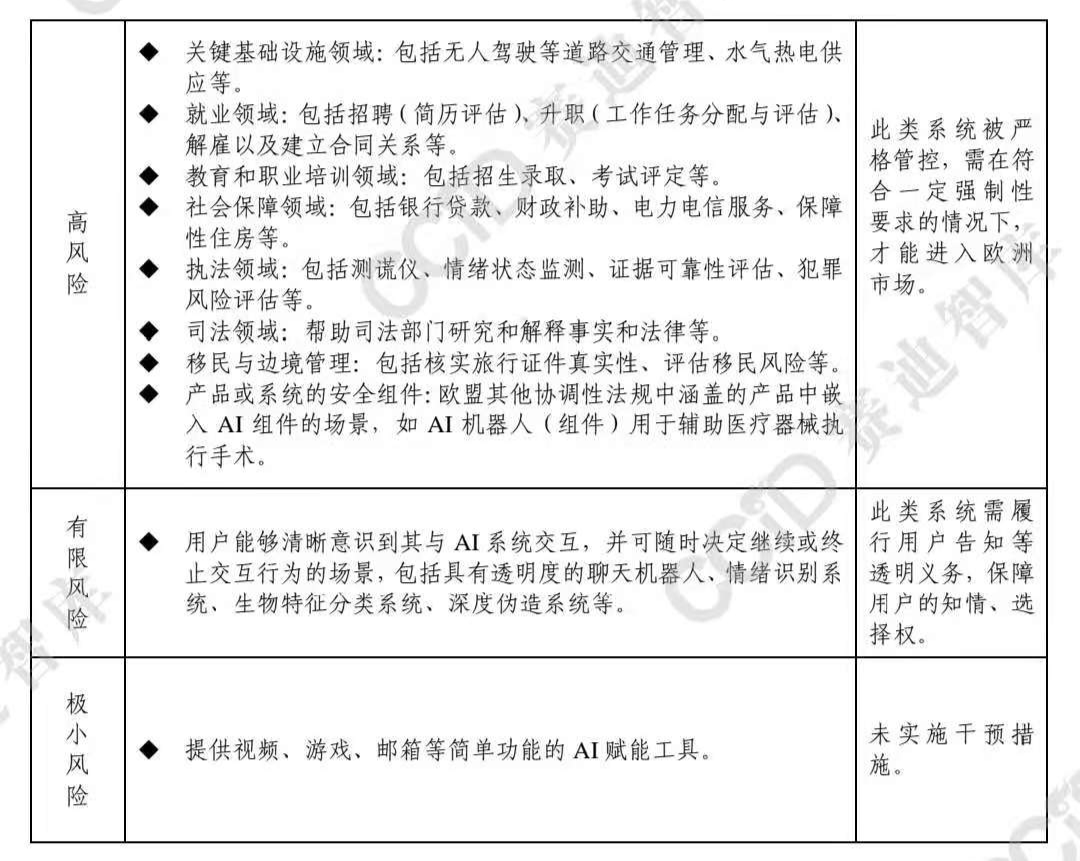

对不同应用场景的 AI 系统实施风险定级,并分别提出规制路径。《法案》基于不同应用场景的风险差异性,将 AI 系统分为 “不可接受、高、有限、极小”四个风险等级,并针对不同级别风险实施不同程度的规制,从而构建起以风险为基础的四级治理体系。

一是将对基本人权和社会公平构成明显威胁的 AI 系统视 为“不可接受”。

二是将可能危及公民人身安全及生活基本权利 场景中的 AI 系统视为“高风险”。

三是将具有特定透明度义务的 AI 系统视为“有限风险”。

四是将提供简单工具性功能的 AI 系统视为“极小风险”。

为在特定领域提供“高风险”AI 系统的企业提出“全生命周 期”式的多重合规要求,旨在增强 AI 产品及服务的透明度。《法案》重点对“高风险”AI 系统的开发、部署和应用等全生命周期提出了系列规范,并要求企业等 AI 系统供应商履行以下透明化义务:

一是在 AI 系统开发过程中,建立风险管理系统、进行数据质量检验、设计用户告知和日志追溯功能、搭建网络安全保障 能力、编制用于监管审计的技术信息文件等。

二是在 AI 系统首次运营前或系统升级迭代后,及时开展合规性评估,并在欧盟委员会建立和管理的大数据库中进行备案登记。

三是在 AI 系统投入使用过程中,建立与 AI 风险级别相匹配适应的售后监测系统与人为监督机制,对 AI 应用中的风险进行监控预警,在发现可能的风险后召回系统处理并通知相关监管机构。

四是在 AI 系统发生故障或严重事故时,应立即采取补救措施,并在半个月内向相关监管部门报告。

设立专项 AI 监督机构,加大监管执法力度。在 AI 监管主体方面,《法案》提出将通过建立欧洲人工智能委员会,推动 AI 新 规则的实施完善,以及后续 AI 标准的制定出台,并借此构建各国监管部门的联络渠道,协调欧盟层面的 AI 监管政策,以保持 AI 监管体系的统一性。

二、《法案》亮点分析

与 GDPR 有效衔接,进一步明确了 AI 系统的数据治理要求。数据和算法是 AI 技术的核心要素,AI 系统通过数据喂养进行算法模型优化,算法模型也应用于对个人数据的深度挖掘,实现基于学习的智能化服务。

搭建具备可拓展性的法律框架,弥补了技术监管的滞后性缺陷。面对飞速发展的 AI 等新兴数字技术,法律的适用性持续时间往往较短,新制定的法律规定可能很快就无法适用于实际情况,难以实现对迭代快速的 AI 技术进行全面监管,AI 领域的法制体系滞后性凸显。

实施对人工智能系统的分类分级监管,构建系统性 AI 治理体系。AI 技术具有跨学科、前沿知识融合等复杂属性,不同 AI 系统在相同场景中可造成不同种类的风险,相同 AI 系统在不同场景中应用也可能带来不同种类或不同程度的风险。

率先建立 AI 监管沙盒机制,探索监管人工智能风险的新模式。技术规制的法律制定常见难点之一就是如何在实现有效监管的同时,兼顾技术创新发展,鼓励企业负责任的创新行为。

三、四点启示

强化 AI 立法,制定具备衔接性与灵活性的法律监管框架。 基于 AI 风险的复杂性、多变性,以及其与数据安全的紧密关联性,在探索 AI 法律规制路径时,可参考欧盟《法案》亮点,增强法律内容的衔接协调与灵活开放特性。

探索分类分级监管路径,依据不同应用场景精准施策。可考虑采用《法案》中的分类分级治理思路,依托对不同场景类别的梳理,以及场景风险对个人生命和生活权利、社会秩序影响大小, 将不同应用场景进行分级,对归属于同一风险级别场景中的 AI 系统进行统一管控,对不同风险级别场景中的 AI 系统分别采取具有不同约束程度的治理方式,从而建立起自下而上限制逐步加 深的“风险金字塔”规制模型。

明确企业在 AI 产品开发、运营过程中的强制性义务,提高 AI 系统的透明度。要求企业在 AI 产品开发过程中,建立完善的 AI 系统风险管控流程,包括开展数据质量检验避免数据投毒等事件发生、建立日志追溯机制强化风险的归因溯源、建设网络安全保障能 力防止数据泄露等。

多措并举构建体系化的 AI 监管机制,制定包容审慎的技术监管措施。

一是建立 AI 监管专项负责机构,及时跟踪和制约 AI 风险。

二是完善标准体系,建立第三方机构开展 AI 风险检测认证。展 AI 算法、透明度、数据安全风险等相关评估。

三是探索设立 AI 沙盒监管,探寻风险制约和创新保护之间的最佳结合点。

关注公众号:拾黑(shiheibook)了解更多

赞助链接:

关注数据与安全,洞悉企业级服务市场:https://www.ijiandao.com/

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

- Bruno:开发者的Git友好型API测试利器

- OpenSSL在Debian上的使用限制

- 微软Edge更新 收藏夹图标悄然改头换面:从黄色变透明

- 日元对人民币汇率2024年1月26日

- 居然有人把 B 站放到本地?为什么?

- 23ICT趋势年会 | 中国移动李晗:千兆光网发展要提速率、强业务、保质量、拓场景

- 大朋E4体验:无需基站就能玩SteamVR,3499元主流价位PC VR来袭

- 比亚迪抢占新山头,蔚小理掉队了

- 新一轮五年规划,AMD锐龙移动处理器全新命名规则来了!

- Go 临界资源的安全问题(引入同步异步处理)

- 年度盛宴即将上演,第十二届中国(泰州)国际医药博览会将于23日开幕

- 我的领导不是人

微信扫码关注公众号

微信扫码关注公众号